微软对 GPT-3 的兴趣反映了越来越多地使用基于转换器的深度学习模型。更多的组织正在使用这些模型,因为它们可以更好地理解语义关系。

微软在关联基于 Transformer 的深度学习时发现的问题之一是,关系中的细微差别通常超出了模型。

微软研究院现在已经创建了一个神经网络,几乎与 GPT-3 的功能相匹配。它拥有 1350 亿个参数,是有史以来最大的通用 AI 模型。根据研究团队的一篇论文,该模型已经在 Bing 中运行。

作为有史以来最复杂的人工智能之一,它接近 GPT-3 可以处理的 1750 亿个参数。

MEB

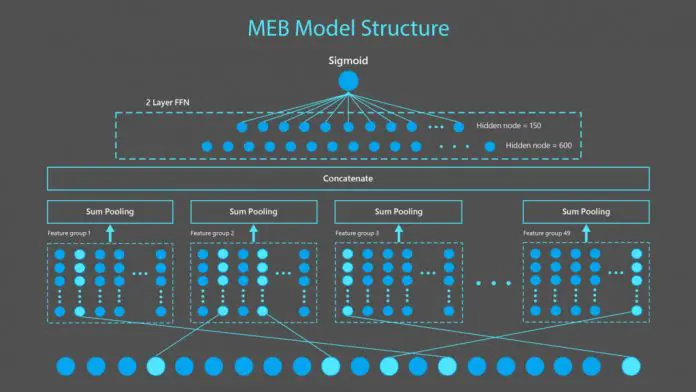

微软将 AI 模型命名为 MEB(Make Every Feature Binary),并在 Bing 搜索引擎中使用它。具体来说,它会分析用户的搜索词并帮助找到最相关的网站。它通过利用其他机器学习算法来提高生产力,从而获得最佳结果。

“MEB 作为基于 Transformer 的深度学习模型的搜索相关性的补充,之所以如此有效,一个原因是它可以将单个事实映射到特征,从而使 MEB 能够更细致地理解单个事实。例如,许多深度神经网络 (DNN) 语言模型在填写这句话的空白时可能会过度泛化:“(blank) can fly”。由于大多数 DNN 训练案例的结果是“鸟类可以飞”,因此 DNN 语言模型可能只会用“鸟类”这个词来填补空白。

正文完